하이퍼파라미터 조절하기

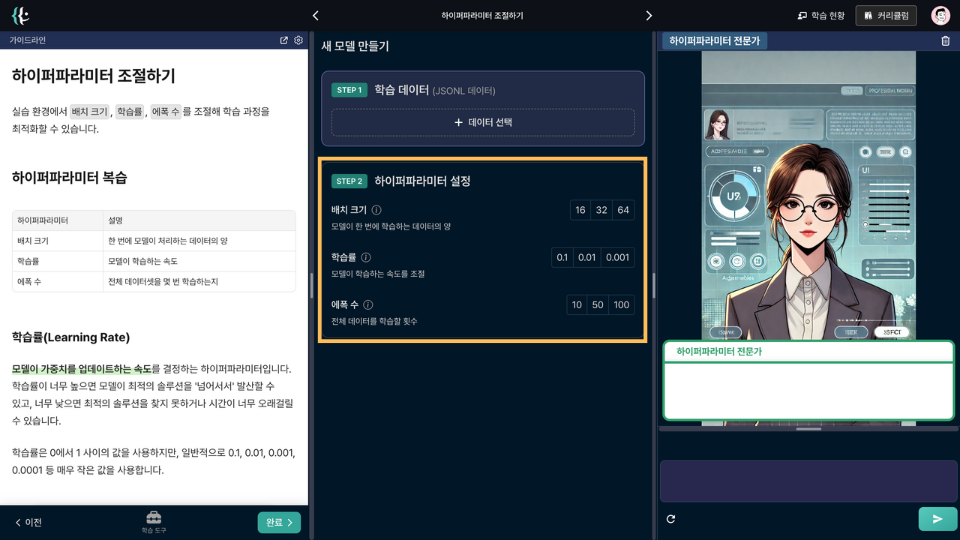

실습 환경에서 배치 크기, 학습률, 에폭 수를 조절해 학습 과정을 최적화할 수 있습니다.

하이퍼파라미터 복습

| 하이퍼파라미터 | 설명 |

|---|---|

| 배치 크기 | 한 번에 모델이 처리하는 데이터의 양 |

| 학습률 | 모델이 학습하는 속도 |

| 에폭 수 | 전체 데이터셋을 몇 번 학습하는지 |

학습률(Learning Rate)

모델이 가중치를 업데이트하는 속도를 결정하는 하이퍼파라미터입니다. 학습률이 너무 높으면 모델이 최적의 솔루션을 '넘어서서' 발산할 수 있고, 너무 낮으면 최적의 솔루션을 찾지 못하거나 시간이 너무 오래걸릴 수 있습니다.

학습률은 0에서 1 사이의 값을 사용하지만, 일반적으로 0.1, 0.01, 0.001, 0.0001 등 매우 작은 값을 사용합니다.

배치 크기(Batch Size)

한 번의 학습에 사용되는 데이터의 양을 의미합니다. 예를 들어, 배치 크기가 32라면, 한 번에 32개의 데이터를 사용해 모델을 학습시킵니다.

일반적으로 사용하는 배치 크기는 16, 32, 64, 128, 256, 512 등 2의 제곱수를 사용합니다. 배치 크기가 크면 학습 속도가 빨라지지만, 메모리 사용량이 늘어날 수 있습니다.

에폭 수(Number of Epochs)

에폭 1번은 전체 데이터셋을 한 번 학습한 것을 의미합니다. 즉, 모델이 모든 학습(Training) 데이터를 한 번 다 사용할 때까지의 과정을 한 에폭이라고 합니다.

에폭 수가 너무 작으면 모델이 충분히 학습하지 못해 성능이 낮아질 수 있고, 너무 크면 모델이 학습 데이터를 외우기만 하고 새로운 데이터에 대한 성능이 떨어질 수 있습니다.

Mission

0 / 1

에폭 수가 많을수록 항상 모델의 성능이 좋아진다.

○

✕

학습 자료

AI 튜터

디자인

업로드

수업 노트

즐겨찾기

도움말